詹姆斯·布赖德尔

我们接触的人工智能其实是对既有文化的大范围盗用。如果我们真觉得这样的人工智能可以给人类带来诸多益处,后果将不堪设想。

| 互联网上的人工智能热潮 |

2021年1月,“开放人工智能”公司发布了一款名为“达力”的产品。用户只需输入一小段文字,简单描述自己想要的图片,稍等片刻,达力就可以生成一张和文字匹配度颇高的图片,效果不比插画师的作品差,但速度更快,而且免费。举例来说,如果输入“用圣–埃克苏佩里的风格画一只带翅膀的猪从月球上空飞过”,你就会得到一幅带有《小王子》作者水彩风格的画作。2022年,达力新版本问世更是在互联网引发了“创作”狂潮。社交媒体上到处都是网友千奇百怪的作品,什幺风格都有。短短几个月后,“开放人工智能”另一款名为ChatGPT的产品再次引爆互联网。这款产品瞄准的是语言,而非图像。比如,你让它用美国诗人艾伦·金斯伯格的口吻给《约伯记》写一篇概要,几秒钟内,你就可以得到一篇像模像样的作品;你让它将金斯伯格的诗作《嚎叫》用咨询公司演示文稿的形式呈现出来,它也可以照做。这些产品拥有靠图像和文字创造新奇事物的能力,有几个人会对这样的能力说“不”呢?

实际上,这些产品依托的是“提示工程”技术:用户输入文本后,系统会基于对文本内容的理解,生成与用户期待最匹配的反馈,有时甚至可以给出超预期的反馈。科技评论员预测,提示工程师将成为最受追捧和最赚钱的职业。未来,代码将不复存在,人类和人工智能系统之间最有效的沟通方式也将变成人类语言本身。届时,我们再也不用学代码了,只需将想法告诉人工智能,剩下的一切它自会处理。我们的想象力有多远,人工智能就可以走多远——人类想象力的边界将成为人工智能天花板的唯一上限。

没多久,市面上就出现了达力的效仿者。没有获得达力内测资格的用户可以尝试达力迷你版(后更名为“人工智能蜡笔”),其功能虽然没有达力强大,但也足以让用户体验一番。与此同时,达力的竞品也相继浮出水面,比如《旅途之间》和《稳定扩散》,它们虽说采用了不同的方式整理和生成图像,但其目的和达力并无二致。短短几个月,人工智能应用的细分领域就涌现出了制作三维模型以及短视频的产品,出品方既有业余爱好者和学术机构,也有谷歌、微软等巨头。

达力这个名字结合了迪士尼动画片主人公瓦力和西班牙超现实主义画家萨尔瓦多·达利的名字。提起瓦力,我们会想到那个在人类废墟上清扫垃圾的可爱机器人;提起达利,我们则会想到他的名言,比如“那些什幺都不屑于模仿的人,什幺也创作不了”,再比如“重要的是传播混乱,而非消除混乱”。

过去一年,人工智能迎来了新风口,以达力和ChatGPT为代表的软件牢牢抓住了大众的想象力。科技巨头曾经想靠区块链和虚拟现实创造新增长点,但无一不折戟而返。这一次,他们终于在人工智能上找到了梦寐以求的增长点。对用户而言,人工智能至少是有趣的,虽然这种新鲜感最多能维持五六分钟。其次,人工智能本身自带光环,会让人联想到科幻小说、巨大的机器人以及超级大脑,光是这种联想就足以让人倍感新奇和兴奋。不过,我们如果能揭开人工智能光鲜的面纱,就会发现事实远非如此。

| 人工智能并非新鲜事物 |

过去几十年,人工智能在学界的基本定义从未变过,其底层技术就是神经网络。神经网络的理论以及实践最早可以追溯到上世纪90年代。彼时,我们可以用神经网络技术生成图片,只不过绝大多数情况下得到的是抽象色块。聊天机器人的历史就更悠久了,早在上世纪60年代,麻省理工学院的约瑟夫·维森鲍姆就以心理咨询师为原型,做出了第一款真正意义上的人工智能聊天机器人“伊丽莎”。你如果说“我好难过”,伊丽莎会问你“为什幺觉得难过啊?”维森鲍姆想借此证明人类的沟通是肤浅的,他并没有打算以此为基础,为未来的产品提供蓝图。

早期的人工智能对世界知之甚少,学术机构也缺乏大规模实验的计算能力。和今日的人工智能相比,早期的产品并不是差在智能上,而是差在数据和功率上。过去20年,科技巨头从我们的文化和日常生活中收集了海量数据,建立了大型数据中心,并配装了功能强大的超级电脑来整理数据。陈旧的人工神经网络也因此脱胎换骨,变得马力十足,也正是这一变化造就了如今的人工智能新风口。

| 盗用艺术家心血生产图片 |

科技公司的数据中心存有数以百万计带标签的图片,人工智能靠分析它们生成新的图片。“带标签”是指每张图片都附带一小段描述图片内容和特征的文字。神经网络“吃掉”这些带标签的图片后,会将形状、颜色、构图等细微的图片特征和特定的词语或短语联系起来,构成数十亿组配对。用户只需输入简单的文字,神经网络就会调动相关配对,依据优先次序将既有的形状、颜色和构图重新排列组合,生成新图片。那幺,这些带标签的原始图片从何而来?

答案是图文数据集。德国非营利机构莱恩发布的图文数据集训练过许多大型人工智能模型,比如《稳定扩散》以及谷歌的图像生成器。莱恩的研究员从网页数据集抓取那些本身附有描述性文字的图片,再将文字图片加工,之后把这些素材以大型图文数据集的形式发布。2022年3月,莱恩发布新的图文数据集,总共含有50多亿组图像–文本对。这些图片是最广义上的“公共”图像——凡是网上出现过的图片,都有可能成为其中一分子。因此,不出意料,这种图文数据集会带来诡异的副作用。

2022年9月,旧金山的数字艺术家拉宾使用了一款名为“我是否被抄了”的软件。艺术家的作品是否沦为了人工智能图像生成模型的“养料”,用“我是否被抄了”一测便知。艺术家马特·德里赫斯特和霍莉·赫恩登共同研发了该软件,想弄清楚人工智能究竟是如何利用艺术家心血的。拉宾用软件扫描了一遍莱恩数据库,发现有一张自己的头像。她一路倒查,找到了照片的源头。她曾经因为一种罕见的遗传病看过医生,治疗期间,医生给她拍过几张照片。这些照片是她病历的一部分,她也在病历上签过字,病历上明确写明一切资料仅限治疗使用。医生于2018年去世,之后,这些照片以某种方式跑到了网上,最后还进了莱恩的图文数据集,成为了神经网络理解和创作图像的“养分”。

“这无异于数字版的收受赃物。有人从我已故医生那儿偷了我的照片,上传到网上,随后照片又被数据集抓取了。”拉宾接受采访时说,“照片泄露本身就够糟了,现在还成了别人产品的一部分。而且,每个人的照片都有可能遭遇同样的事。未来,照片被滥用的可能性非常高。”

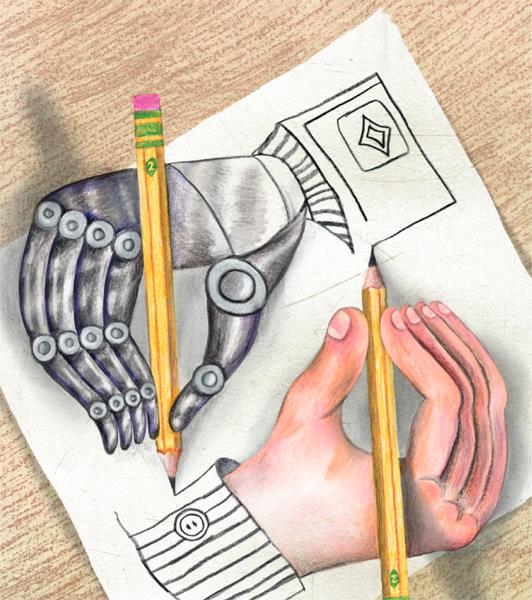

面向大众的人工智能产品,不管是主攻图像还是主攻文字,抑或是那些基于数据的应用软件,其实都是对既有文化的大范围盗用,只是这个范围确实大到了我们难以想象的地步。不论是公众的还是私人的,不论是法律还是其他层面,那些被人工智能“吃掉”的文字和图片都属于“合理使用”的模糊范畴。先进的神经网络里究竟发生了什幺,我们很难从外部理解。不过,有一点可以肯定:人工智能生成的结果远谈不上神奇或原创,所有一切都是依托历代艺术家既有的作品拼凑出来的,这些艺术家既没有得到应有的认可,也没有得到任何经济回报。

换句话说,人工智能的图文生成系统本质上是纯粹的原始积累:盗用绝大多数人的心血,为硅谷少数几家科技巨头及其亿万富豪老板创造财富。这些公司的赚钱模式就是将触角伸到人们日常生活的方方面面,其中也包括最私密和最具创造力的部分,比如我们的私密对话、偏好以及梦想。它们将我们的梦想据为己有,一如往日的地主和强盗贵族将土地圈为私有;它们承诺这样做可以为人类提供前所未有的新体验,让我们享有接触人类所有知识的机会,并创造人与人沟通的新方式。但是,真相并非如此,它们所做的无非是将我们的梦想打包兜售给我们,还宣称这是人工智能的结晶,它们真正能兑现的承诺就是借此捞到更多的钱。

| ChatGPT只是看似聪明 |

2022年11月,“开放人工智能”发布ChatGPT。这一产品的问世重塑了我们的观念,让我们重新思考人工智能和人类创造力互动的可能。它的结构与聊天机器人类似,但其功能远比传统聊天机器人强大。你只要会用,就可以让它帮你写代码,解决数学难题,写作任务也不在话下,书评、学术文章、婚礼致辞、法律合同,你都可以找它代笔。

对于那些一想到写邮件或者写文章就头疼的人,ChatGPT显然是一大利器。不过,和图像生成器一样,它也可能让一些人丢掉饭碗。许多学校担心学生会用它写作业,为了避免此类情况,校方出台规定,禁用ChatGPT。学术期刊《自然》也发布规定,禁止将ChatGPT列为学术论文作者。但是,机构本身其实也有可能滥用这款聊天机器人。今年2月,范德堡大学皮博迪教育与人类发展学院做了一件令学生震惊的事:美国一所学校发生枪击案后,学院给学生群发了一封吊唁信,并为学生提供了建议,但这封电子邮件的落款竟然是ChatGPT。这样的事提醒我们,人工智能到底能否在诸多领域代劳,似乎还需要我们进一步思考。

倘若用ChatGPT完全替代我们的日常交流不合适,那让它充当我们的助手,帮助我们从浩如烟海的信息中快速提取想要的信息如何?微软已经在这个方向先行一步了。它的做法是将自家搜索引擎必应和ChatGPT结合起来,这一举动也提升了必应的知名度。这段时间,网上确实兴起了“遇事不决问ChatGPT”的潮流,但它的回复能否称得上真的知识,还要打上问号。

不久前,我和ChatGPT互动过一次,让它给我推荐几本与多物种生命民主有关的书。多物种生命民主是一个新兴的研究领域,主要强调政治决策应该把非人类物种的生存纳入考虑范畴。“你能不能给我推荐几本这方面的书?”我问道。它很快开出书单,并且附上了颇具说服力的推荐语。太牛了!但我一查才发现,推荐的四本书里只有一本真实存在。它提到几点与多物种生命民主有关的概念,也都是从右翼手册打包拷贝过来的。比如,它告诉我多物种生命民主名义上是在维护动物权益,实则是对环境有害的自由派观念,并且会导致产权扩张。

ChatGPT能跟我说这些,并不是因为它站在右派立场,而是因为它本身就很蠢。它读取了互联网大部分的内容,知道人类语言听上去应该是怎样的,但它从未和现实有过任何交集。它擅长生产像模像样的话语,但那些话顶多也就是陈词滥调和平庸之语。它并没有能力生成与真实世界存在真实关联的语句。倘若有人告诉你ChatGPT可以仿效人类意识或者说接近人类意识,你可千万别上当。

越来越多的人相信人工智能知识渊博,可以说出有意义的内容。这种想法非常危险,任其发展,人类的集体智慧会受到污染,我们的思考能力和批判性思维也会受到损害。科技公司声称,大家有疑问,可以让ChatGPT解答;评论员宣称,可以让ChatGPT走进课堂,充当助教。果真如此,我们与可靠合法的信息源只会越隔越远,因为我们之间插入了ChatGPT的套话,并且套话与可靠信息的界限会变得越来越模糊,直至我们看不出区别。

人工智能对地球也有害。2019年发布的一篇研究报告指出,单是训练一款人工智能模型,整个过程释放的二氧化碳就可以达到284吨,相当于五辆美国汽车一生的碳排放量。据估计,未来五年,人工智能所造成的碳排放会上涨近50%。从气候变暖到海洋酸化,从森林大火到物种灭绝,每一项罪责都与人工智能脱不了干系。从这个角度看,眼下还有什幺比追捧人工智能更蠢的事吗?

| 探索新可能 |

我们不妨后退一步,倘若当下的人工智能应用模式让人感到无比凄凉,我们是否还有别的选择?我们能否将人工智能用于正途,而不是让它去剥削、苛待、误导或顶替我们?答案是肯定的,只要我们愿意跳出公司霸权对人工智能的定义,我们就可以有其他选择。

有人就绕开了公司霸权,试图用人工智能拯救濒危的土着语言。联合国估计,平均每两周就有一门土着语言消失,讲这门语言的人的智慧经验也会跟着一并消失。土着语言濒危的全球性问题是几百年来殖民主义以及种族同化政策带来的恶果,而如今崛起的主流机器语言学习模型更是进一步加剧了这一趋势。也就是说,主要语种的影响力会因为这些模型进一步加强,而弱势语种则会因此被进一步边缘化。

新西兰小型非营利电台“海酷”的节目采用毛利语播放。语言在科技领域并非对等,有的强势,有的边缘。海酷电台为了对抗这种不平等,将20余年的广播录音全部转化成了电子版,希望惠及语言研究人员和毛利族社区。许多俚语和俗语都失传了,没人听得懂。海酷电台为了将音频资料转为文字,专门训练了自己的语音识别模型。如此一来,该模型就可以“听懂”音频,将多年的电台录音转成文本。

经过几年努力,海酷电台成功打造了一套高精度开源毛利语识别系统。这一系统成长如此之快,离不开毛利族社区的贡献。海酷电台把能联系到的毛利族社区都联系了一遍,邀请毛利人朗读文本,充实语料库。海酷电台的成功范例为土着语言的复苏蹚出一条新路,加拿大东南部的莫霍克人以及夏威夷土着都跟着做起了类似项目。

之前,有外国企业想建立自己的毛利语语音识别模型,联系过毛利人,希望他们伸出援手。海酷电台动员毛利族社区拒绝这一邀请:“这些人排挤我们的语言,用蛮力迫使我们的祖父母放弃了自己的语言,如今又想把我们的语言做成服务卖给我们,赚我们的钱。”海酷电台的办法是,毛利人贡献的一切数据都归毛利族社区所有,这样既可以帮助毛利人复兴自己的语言,又可以避免电子殖民主义。

这波人工智能浪潮教会了我们一个道理:公司理解的人工智能具有非常大的局限性。如果将利益最大化视作终极目标,那股东价值将成为衡量一切的尺度,如此一来,我们对艺术、想象力、审美还有情感的追求自然会大打折扣。实际上,我们理应从人工智能中获得更多,但前提是我们有能力参与其中。不要怕,它们并没有那幺复杂,正如科幻作家厄休拉·勒古恩所写:“科技,只要我们想学,还是学得会的。”

[编译自英国《卫报》、美国《纽约客》]

编辑:要媛