路明 丁丽

摘 要:随着5G技术的发展,5G用户的流失预警已成为移动运营商的重要任务。然而,传统的用户流失预警方法在5G营销领域存在准确性和可靠性不高的问题。为了解决5G用户流失预测问题,文章将集成九大机器学习算法,结合5G降档以及离网用户的标签数据和消费行为,构建一个基于集成学习算法的用户流失预警模型。研究结果表明,基于集成学习算法的5G用户流失预警方法具有较高的准确率、实时性和可靠性,可以有效地提高5G用户流失预警的效率。

关键词:集成学习算法;5G营销;用户流失预警

中图分类号:F832.4 文献标识码:A 文章编号:1005-6432(2024)04-0195-04

DOI:10.13939/j.cnki.zgsc.2024.04.049

5G技术的发展为用户提供了更快的网络速度、更多的应用服务、更高的网络安全性,以及更低的网络延迟,然而,由于用户的使用习惯和消费需求的变化,5G用户的流失率也不断增加,这对移动运营商的业务发展构成了巨大的挑战。因此,如何通过海量用户数据准确地预判5G用户的流失趋势并针对性地挽留,已经成为当前5G市场营销领域研究的热点。文章旨在探索基于集成学习算法的5G用户流失预警方法,首先,收集了5G用户的使用习惯和消费水平数据,并对数据进行预处理,以便进行后续的分析。其次,文章提出了一种基于集成学习算法的5G用户流失预警方法。集成学习算法是一种有效的机器学习方法,可以将多个机器学习模型结合起来,提高模型的准确性。基于安徽移动公司2022年的用户数据,文章构建了一个基于用户标签的预警模型,并采用集成学习的方法,将随机森林、神经网络、Xgboost以及Catboost等九大机器学习算法结合起来,最后对集成学习算法进行评估,验证了模型的有效性和可靠性。

1 研究现状

随着5G技术的发展,通信行业面临着市场竞争激烈、产品同质化严重、客户流失等诸多问题,5G用户流失问题已经成为当前研究的热点。目前,已有一些关于移动通信客户流失的研究,对客户流失预测方法进行了前期研究,以单一机器学习模型和数据挖掘为主。例如,徐草等通过语气算子的运用、信息转换公式等,把模糊语言变成精确概率,并将其应用于客户流失的预警与分析[1];邓小龙等引入人工智能遗传演化思想,对基于心理学扩散模型的SPA预测流失算法进行改进,提出一种遗传演化预测算法,增强了预测模型泛化能力[2];林涛综合运用了统计方法和机器学习方法,利用正则化逻辑回归算法,对客户流失预测的准确率基本达到89%以上[3];李兵等利用决策树和K-Means++聚类,对传统的随机森林算法进行了改进,获得了高精度、低相似预测算法[4];王小超等以电信运营商为对象,分别使用支持向量机、随机森林、KNN、BP神经网络4种算法进行研究,对比各种模型的准确率与召回率,发现采用BP神经网络算法构建的数据模型预测效果良好[5];乔健等将客户生命周期价值指标引入随机森林CART分类树算法特征选择过程,有效地提高了客户流失预测模型准确率[6]。

近年来,很多学者运用集成学习模型进行用户流失预测,例如,余路将Logistic回归、BP神经网络与决策树三种模型相结合,与单一模型预测结果相比,组合模型的预测效果更好[7];Jayaswal等人以电信用户的数据为研究对象,分别构造决策树模型、随机森林与GBDT的集成模型,证明随机森林与GBDT明显好于单个决策树;武小军等人提出了支持向量机、CW-SVM、BP神经网络和改进的SMOTE+AdaBoost用于用户流失预测,改进后的方法能够有效地确定类别中高价值的客户群体,并提高流失客户及非流失预测准确性[8];汪明达等人提出了两个混合模型来预测电信用户的损失,分别为神经网络与机器学习集成模型、朴素随机过采样与投票结合的集成模型,研究表明,朴素随机过采样投票集成模型准确率较高;Ahmed等人对逻辑回归、朴素贝叶斯、多层感知机、决策树、随机森林等、GBDT分别进行检验,研究表明,随机森林模型与GBDT模型预测效果明显好于其他单一模型。为进一步增强该模型预测能力,采用Stacking方法实现了模型集成。

从上述文献可以看出,用户流失预测领域研究已经取得了显着的进步,研究人员对用户流失的预测方法和思路存在一定差异。随着5G通信技术和产品的迭代,现有的用户流失模型缺乏针对5G套餐用户的预测。在5G市场中,降档和离网是用户流失的关键预警行为,对于研究5G用户流失预警模型是非常有必要的。因此,本研究通过降档离网用户和非降档离网用户在近几个月内的相关数据,验证最核心的机器学习算法,通过核心标签指标和集成学习模型,进行用户流失预测分析,从而准确定位营销时机,高效采用营销策略,全面提升营销效率。

2 研究设计

2.1 数据提取

本研究数据来自安徽移动GBase数据库,随机抽取了762191条用户数据,其中降档离网用户仅有4243人。为了更好地进行模型预测,需要平衡降档离网人数和非降档离网人数,分成两步提取数据。第一步:提取2022年10月“是否降档离网”标记为0,同时2022年11月“是否降档离网”标记为1的用户500000人,作为正样本;第二步:提取2022年10月“是否降档离网”标记为0,同时2022年11月“是否降档离网”也标记为0的用户500000人,作为负样本。由于上次提取的762191条数据中也含有“11月降档离网用户”(3905人)和“10月和11月均未降档离网用户”(254022人),将这部分用户也加入样本中,最终得到降档离网用户503905人(正样本),未降档离网用户754022人(负样本)。

2.2 数据清洗

在数据生产、运输、存储的过程中可能会产生大量的噪声点,如缺失、重复、错误、异常等情况。数据清洗就是要将无效数据清洗干净,从而提高数据质量,增强预测结果的可信度。首先对初始标签进行缺失值判断,查看标签是否完整,发现部分标签缺失较多数据,因此选择直接删除这部分用户。除了缺失值,在收集数据时也发现有部分标签的值中含有“不详”(以“Z”表示)的部分,因此将该标签视作无效标签删除。剩余标签中,“Z”的存在较少,因此这样的标签仍然具有预测能力,只需要把标签未知的这部分用户删除即可。

2.3 数据标准化

数据标准化指的是将样本的属性缩放到某个指定的范围。在采集的数据中不同属性的数据具有不同的量级,标准化后可以让不同维度之间的标签在数值上有一定比较性,寻优过程范围变小,更容易收敛到最优解。文章采用Z-score的方法对数据进行标准化处理。

2.4 特征工程

特征工程是从用户基本数据、订购数据、行为数据中筛选用户信息,让其最大限度地表征用户的所有标签,并尽可能地剔除冗余数据的过程。可以从以下几个方面考虑选择特征:

方差筛选:在数理统计中,方差是各变量值与其均值离差平方的平均数,是测算数值型数据离散程度的最重要的方法。方差越大,数据的波动就越大,方差越小,数据的波动就越小。如果一个特征不发散,也就是说样本在这个特征上基本没有差异,这个特征对于预测就没有什幺用。因此需要消除方差为0或较小的特征。在本研究中设置阈值为0.01,然后筛选掉方差小于阈值的特征,剩余46个标签。

相关性分析:首先与目标高相关的特征应该优先选择,与目标低相关的特征应该适当舍弃。其次特征之间如果存在某种相关或者高度相关的关系,会产生多重共线性的问题,使模型估计失真或难以估计,最后需要进行剔除。变量相关性剔除的方法有很多,本研究主要通过计算两两特征的相关系数,采用皮尔逊相关系数计算,皮尔逊相关系数定义为两个变量之间的协方差和标准差的商。设置相关系数的阈值为0.7,若两特征的相关系数大于0.7则代表他们高度相关,需要删除其中一个。计算所有特征两两之间的相关系数,将大于阈值的特征进行剔除,最终剩余36个标签。

卡方检验:卡方检验专门针对分类问题的相关性过滤,可以对离散型特征进行筛选,是用来检验定性自变量对定性因变量的相关性,构建统计量χ2进行估计。之后根据自由度来对照卡方分布的临界值表进行判断,自由度为K-1。χ2就是自变量对因变量的相关性,按照计算出的卡方统计量由高到低排列。文章对卡方检验p值大于0.05的特征进行筛除,最终保留31个标签。

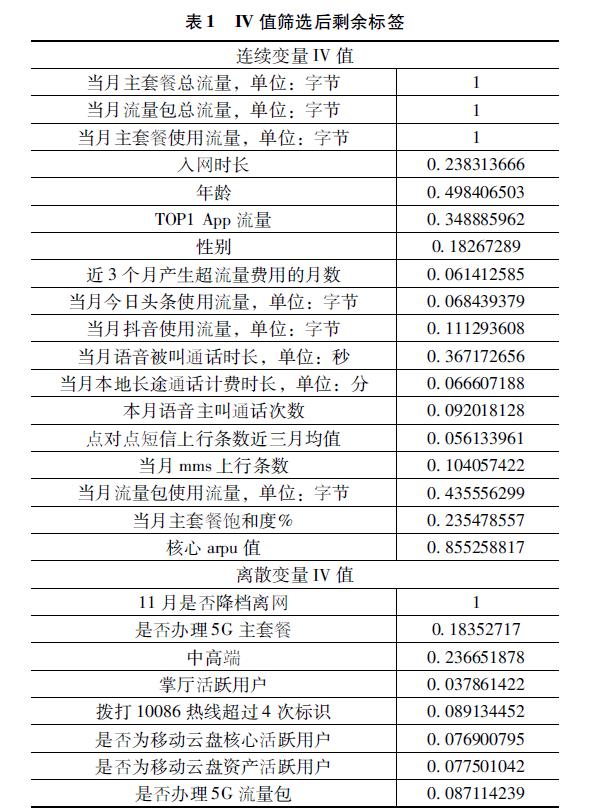

IV值筛选:在进行特征工程之前需要对特征进行重要性筛选,由于标签较多,所以需要用一种方法帮助衡量什幺变量应该进入模型,什幺变量应该舍弃,本研究使用了IV值筛选方法,IV值的含义是信息价值或信息量。对于变量来说,IV值越大就表示预测能力越强。由于连续变量与非连续变量计算方式不同,因此首先将连续变量与非连续变量分离,最终得到连续变量18个,非连续变量13个。然后将连续变量分箱计算IV值,筛选出IV值大于0.03的标签进行保留,最终保留18个标签。对非连续变量不需要进行分箱,直接计算最终保留8个标签,因此通过IV值计算最终保留26个标签。筛选结果如表1所示。

2.5 模型构建

经过特征工程后,将提取的标签作为输入,构建一个基于集成学习算法的模型,采用决策树、随机森林模型、Xgboost、Catboost、支持向量机、逻辑回归模型、最近邻(KNN)算法、朴素贝叶斯算法、BP神经网络算法,用于5G用户流失预警推荐。

决策树:作为机器学习算法中一种基本的分类和回归算法,决策树学习是以实例为基础的归纳学习。模型呈树形结构,主要由节点和有向边组成,代表的是对象属性与标签值之间的一种映射关系。

随机森林:随机森林是由多个决策树组成。在处理分类问题时,随机森林本质上是对许多决策树进行打包处理(bagging),最后以所有决策树的投票来确定最终分类结果。文章中通过python的sklearn库调取模型进行应用,随机森林决策树数量为1000,最大深度为40。

Xgboost:Xgboost算法属于GBDT梯度提升决策树的一种,通过对决策树进行提升(boosting)处理来实现集成。随机森林对决策树进行打包时最终输出的结果由所有决策树投票产生,而Xgboost每一次迭代都会在上一次迭代的基础上进行。文章中Xgboost树的数量为1000,最大深度为40。

Catboost:Catboost是嵌入了自动将类别型特征处理为数值型特征的创新算法。首先对分类特征做一些统计,计算某个类别特征出现的频率,之后加上超参数,生成新的数值型特征,且使用了组合类别特征,可以利用特征之间的联系,丰富了特征维度。

支持向量机:通过一条支持向量来实现对数据的划分,并且力求使向量到两类数据最近的样本距离最大。它是机器学习中最流行的模型之一,特别适用于复杂的中小型数据集分类。

逻辑回归模型:逻辑回归也被称为广义线性回归模型,是一种简单的二分类模型,与线性回归模型的形式基本上相同。逻辑回归在线性回归的基础上,套用了一个逻辑函数。

最近邻:最近邻算法从现有特征出发,如果i与某一类别的群体比较相似,则i就属于这一类。因此,在最近邻算法中最重要的是K值的选取和点距离的计算,本研究通过交叉验证的方式最终确定K值选取为5时预测效果最好。

朴素贝叶斯:朴素贝叶斯算法对于给出的待分类项目,求解在此项目出现的条件下各个类别出现的概率,哪个最大就认为此待分类项属于哪个类别。只需要求出在特定特征下某个新值是某个类别的概率即可。

神经网络模型:神经网络大体可以分为输入层、隐藏层以及输出层。为了充分地利用数据中的信息,可以通过在输入层与输出层之间加入隐藏层的方式来将数据投影到高维空间中,并在高维空间对数据进行划分来更好地对数据进行线性划分。文章中神经网络设置两层隐藏层,每层具有50个隐藏神经元,正则化惩罚系数为10-5,求解方式为随机梯度下降。

3 实验结果

3.1 模型评估

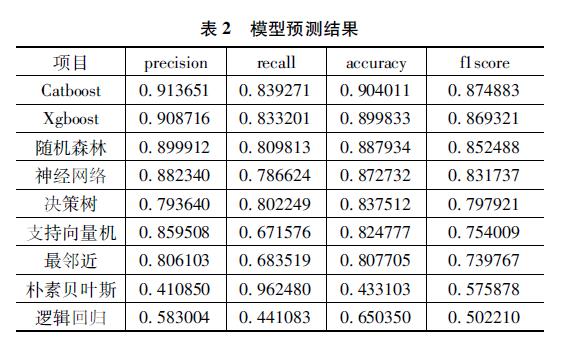

在模型评估方面,从precision、recall、accuracy、f1score四个角度来使用10折交叉验证对模型进行评估。

查准率(precision):指被分类器判定正例中的正样本的比重。

查全率(recall):指的是被预测为正例的占总的正例的比重。

准确率(accuracy):代表分类器对整个样本判断正确的比重。

f1score:查准率和查全率的综合。

交叉验证:指在给定的建模样本中,拿出其中的大部分样本进行模型训练,留小部分样本用刚建立的模型进行预测,并求这小部分样本的预测误差,记录它们的平方加和。这个过程一直进行,直到所有的样本都被预测了一次而且仅被预测一次,比较每组的预测误差,选取误差最小的那一组作为训练模型。表2展示了交叉验证结果:

由表2可知,按模型效果大体可以将模型分为三个层次:逻辑回归和朴素贝叶斯位于第三梯队;最邻近、支持向量机、决策树有效性位于第二梯队;随机森林、神经网络、XGBoost以及CatBoost有效性处于第一梯队。

3.2 模型进一步处理

为了提高模型稳健性,现选择随机森林、神经网络、CatBoost以及XGBoost模型以打包(bagging)的形式进行集成,集成后的学习模型采取以下规则对客户是否为潜在降档离网客户进行判断:对客户k来说,分别用随机森林、神经网络、XGBoost以及CatBoost对当前客户进行预测,如果有三个或三个以上模型预测客户k为潜在流失客户,则认为客户k为潜在流失客户,否则认为客户k不是潜在流失客户。

经测试,得到多模型的准确率为0.93220,远高于上述所有单个模型,但由于高准确率是由严格的条件而来的,因此查全率的表现平平,查全率为0.80593,f1score值为0.86447,总体上略低于CatBoost和XGBoost,因此是否运用多模型,需要考虑准确与查全的平衡,若要求高准确率,则可使用多模型预测,若既要求准确也要求查全,则使用单模型CatBoost或XGBoost是较好的选择。

4 结论

随着5G技术的发展,5G用户流失预警方法的研究受到了越来越多的关注。文章研究了基于集成学习算法的5G用户流失预警方法,具体来说,提出了一种基于集成学习算法的5G用户流失预警方法,该方法利用多种机器学习算法,从查准率、查全率、准确率、F1值多指标维度对模型进行评估,发现随机森林、神经网络、XGBoost以及CatBoost效果最好,效果在所测试模型中处于第一梯队。另外,为了提高预测的稳健性,文章对测试效果较好的模型进行打包集成处理,并将集成后的模型作为最终预测模型。

本研究主要贡献有以下几点:首先,构建了5G市场用户标签库,通过不断优化标签,最终形成一个精准的标签库,从而使模型产生更好的预测效果;其次,构建了5G用户流失预测模型,对约100万用户数据进行了训练,帮助运营商找到合适的客户进行针对性营销,降低5G业务的用户流失率。未来的研究应该更加注重技术的可扩展性和可维护性,以满足不断变化的市场需求。例如,可以采用增量学习或联合学习的方法,以更好地适应市场的变化。也可以改进标签选择和标签组合技术,提高用户标签库的准确性和效率。

参考文献:

[1]徐草,李敏.模糊贝叶斯网在通信行业客户流失预测中的应用研究[J].合肥工业大学学报(自然科学版),2010,33(10):1567-1571.

[2]邓小龙,王柏,吴斌,等.遗传演化SPA流失预测算法及并行化[J].计算机科学与探索,2011,5(5):433-445.

[3]林涛.基于Logistic回归的电信宽带客户流失预警分析[J].中国新通信,2019,21(11):147-148.

[4]李兵,陈俊才.基于TMRF算法的电信客户流失预测方案研究[J].数字技术与应用,2021,39(4):116-121.

[5]王小超,张勇.基于BP神经网络的电信用户流失预测研究[J].绥化学院学报,2021,41(11):148-151.

[6]乔健,诸佳慧,严康桓.基于随机森林CART特征选择改进算法的电信客户流失预测模型[J].电信工程技术与标准化,2022,35(3):78-82.

[7]余路.电信客户流失的组合预测模型[J].华侨大学学报(自然科学版),2016,37(5):637-640.

[8]武小军,孟苏芳.基于客户细分和AdaBoost的电子商务客户流失预测研究[J].工业工程,2017,20(2):99-107.

[基金项目]本文系安徽移动公司研发项目“安徽移动5G业务互联网链路营销体系研究研发服务合同”的阶段性成果(项目编号:202101243)。

[作者简介]路明(1980—),男,汉族,安徽芜湖人,硕士,中国移动通信集团有限公司安徽分公司工程师,研究方向:5G业务;丁丽(1989—),女,汉族,安徽六安人,中国移动通信集团有限公司安徽分公司中级经济师,研究方向:5G业务。